Narodziny radzieckiego systemu obrony przeciwrakietowej. Koniec maszyn modułowych

Pomyślnie rozwiązano podstawowe problemy arytmetyki modularnej, zaakceptowano maszynę, prototyp działał doskonale, napisano algorytmy. Do tej pory nikt nie mógł przewidzieć, jak to wszystko się potoczy, a pracownicy na fali euforii postanowili nie poprzestawać na zakończonym już sukcesem (jak im się wydawało) projekcie i zbudować coś innego.

Ten artykuł zawiera wiele ilustracji podobnych zachodnich projektów, niestety jest to zabieg konieczny, gdyż nie udało się znaleźć fotografii związanych z późnymi pracami Judyckiego i zespołu SVT w żadnym otwartym kodzie źródłowym (a nie wiadomo, czy zdjęcia owe sekretne prototypy w ogóle istniały).

Tworząc 5E53 postawiono monumentalny fundament pod dalsze badania – dopracowano w końcu matematyczne podstawy pracy z SOC, metody poprawy odporności na uszkodzenia, stworzono peryferie (a stworzenie ich w ZSRR było osobnym wyczynem, porównywalnym z rozwojem superkomputer, narzekali na monstrualną jakość sowieckich napędów, drukarek i innych rzeczy, nawet fanatyczni komuniści). Do flashowania wyprodukowano wygodny 256-bitowy układ diod na podłożu dielektrycznym DMR-256, a jego produkcję zorganizowano w firmie Mikron, przetestowano metody montażu hybrydowych układów scalonych o dużej gęstości.

Nie zapominajmy, że pracownicy Juditsky'ego nie wyróżniali się starczym skostnieniem charakterystycznym dla wielu oficjalnych sowieckich szkół naukowych, nie było tam zapachu gerontokracji, wszyscy byli (podobnie jak ich szef) młodzi i odważni i chcieli tworzyć dalej. Planowali udoskonalić kolejną wersję 5E53, zmontować ją na prawdziwych chipach i zawrzeć szereg jeszcze bardziej zaawansowanych rozwiązań technicznych (na szczęście we wstępnym projekcie nowego superkomputera nie było już żadnych ograniczeń dotyczących pracy konkretnie z algorytmami obrony przeciwrakietowej ). Rozpoczęła się prawdziwa rewolucja w dziedzinie superkomputerów, napędzana przyjazną konkurencją z grupą Kartsev - Yuditsky zrozumiał, że jego maszyna jest obiektywnie wolniejsza, spaliła go chęć wyciśnięcia takiej samej liczby operacji na komputerze modułowym.

Wymyślony potwór był radykalny i postępowy, nawet jak na standardy niesamowitej zachodniej architektury lat 1980. (kiedy wszystko próbowano zwiększyć produktywność). Oprócz modułowej arytmetyki musiał być modułowy, rekonfigurowalny (!) i ze sprzętowo-mikroprogramową implementacją DLL (!), i to nie byle jaki, ale straszny i legendarny PL/1 (przy wsparciu którego IBM ucierpiał, ale który był bardzo popularny w ZSRR) lub jeszcze dziwniejszy język - IPL (Information Processing Language), opracowany przez Alana Newella (Allen Newell), Cliffa Shawa (Cliff Shaw) i Herberta Simona (Herbert A. Simon) z RAND Corporation i Carnegie Institution około 1956: być może pierwszy funkcjonalny język programowania na świecie, typ asemblera, skoncentrowany na pracy z listami).

Te bardzo nieortodoksyjne innowacje należy omówić osobno, zwłaszcza że pomysł wsparcia sprzętowego dla NED został z powodzeniem zapożyczony przez Burtseva do jego Elbrusa. Wszystko zaczęło się w USA od słynnej firmy Burroughs, która na początku lat 1960. zdecydowała się wejść na rynek mainframe.

B5000

Tak narodził się B5000 - wspaniała maszyna, która o dekadę wyprzedziła rozwój architektury komputerowej.

Opracowany przez zespół kierowany przez Roberta Bartona w 1961 roku, komputer typu mainframe był pierwszym z serii dużych systemów Burroughs, które działały do późnych lat 1980. XX wieku i charakteryzowały się unikalną architekturą, nie używaną przez żadnego innego producenta. Znany informatyk John R. Mashey wymienił to jako jeden ze swoich najbardziej podziwianych wynalazków:

Ekspert od maszyn z Burroughs, profesor Uniwersytetu Wirginii, Alan Bateson, w wywiadzie dla magazynu Cokolwiek się stało z siedmioma krasnoludkami?, powiedział:

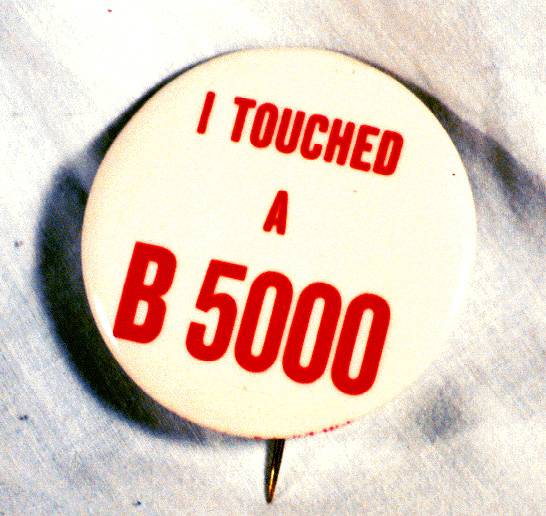

W latach 1960. i 1980. wiele firm produkowało różne przypinki do klapy na cześć siebie, swoich produktów i wszelkich technologii, odznaki te były noszone przez pracowników firmy, rozdawane na wystawach i prezentacjach oraz wykorzystywane w reklamie. Obecnie wiele z nich ma znaczną wartość kolekcjonerską. Pierwszy duży komputer Burroughsa wywarł tak wielkie wrażenie nawet na jego twórcach, że wydano na jego cześć plakietkę z chyba najbardziej oryginalnym napisem reklamowym: „Dotknąłem B5000” (dotknąłem B5000). Jest to również tytuł książki wspomnień z 1985 roku autorstwa znanego informatyka i programisty, specjalisty w dziedzinie teorii i kompilacji języków, który pracował w Burroughs nad jej wersją Algola Richarda Veychoffa (Richard Edwin Waychoff).

Ta sama odznaka (z osobistej kolekcji Ole Hagena Jensena)

Co jest tak wyjątkowego w zbudowaniu przez Boba Bartona i jego zespół?

Wiedzieli, że wchodzą na rynek dużych systemów znacznie później niż ich konkurenci z IBM, RCA i innych, więc musieli zaoferować coś naprawdę wyjątkowego.

Ponadto mieli okazję zapoznać się z architekturą prezentowanych już systemów i zdali sobie sprawę, że wszystkie mają pewne wspólne wady, skoncentrowane w obszarze, bez którego najbardziej zaawansowany komputer jest bezużyteczny - oprogramowaniu. Maszyny były dostarczane oddzielnie od oprogramowania, a wszystkie programy pisane były z reguły przez firmę, która kupiła komputer od podstaw i dla siebie, nikt nawet nie pomyślał o wygodzie programowania, oddzielono architekturę od oprogramowania. Komputery zostały opracowane przez specjalne grupy inżynierów, którzy nawet nie myśleli o tym, jak łatwo lub trudno byłoby opracować programy dla ich maszyn. B5000 miał dać odpowiedzi na wszystkie te pytania.

Był to pierwszy komputer na świecie, który został opracowany jako pojedynczy kompleks sprzętowo-programowy i integralny system, w przeciwieństwie do S/360, dla którego IBM nie zdołał nawet przypomnieć pierwotnie planowanego OS/360 (zresztą ten praktyka oddzielnego projektowania została zachowana w IBM iw końcu stała się dominująca, w tym systemy instrukcji x86, PPC i ARM). Projektowanie maszyny bez uwzględnienia kodu wykonywalnego doprowadziło w latach 1980. do licznych kul przy wdrażaniu oprogramowania i systemów operacyjnych, co pośrednio wpływa na jakość dzisiejszego oprogramowania.

W przypadku B5000 wszystko było inne. Od samego początku był projektowany w połączeniu z językiem, systemem operacyjnym i oprogramowaniem systemowym. Jego główną cechą architektoniczną było pełne wsparcie sprzętowe dla języków wysokiego poziomu, oparte na dwóch innowacjach - procesorze stosu i pamięci tag-descriptor.

B5000 nie miał asemblera, jego procesor był w stanie bezpośrednio wykonywać instrukcje HLL. Podczas opracowywania pojawiło się pytanie, który z języków wybrać jako główny? W tamtych latach było ich zaledwie kilka, ale wybór padł na najpotężniejszy język akademicki, dla którego właśnie pojawił się nowy standard – Algol-60. Stał się głównym językiem systemu, dodatkowo zaimplementowano dobre wsparcie dla Cobola (w większości obejmowało to pracę z potężnymi operatorami łańcuchowymi) oraz Fortrana. Tak więc cała architektura B5000 została zbudowana wokół bardzo zaawansowanego języka, na przykład na długo przed pojawieniem się dyrektywy #define w C, podobny mechanizm był używany w B5000 i był wbudowany w sam język, a nie był poleceniem preprocesora .

Większość innych producentów komputerów mogła tylko pomarzyć o wdrożeniu kompilatora Algola ze względu na jego złożoność i wyjątkowo powolną implementację oprogramowania. Uważano, że osiągnięcie akceptowalnej prędkości podczas korzystania z niego było nierealne, a jeśli nie korzysta się ze wsparcia sprzętowego, tak właśnie było (w szczególności jest to jeden z powodów, dla których Algol jako język nie zyskał szerokiego ówczesna popularność). W Burroughs młody student, legendarny Donald Knuth, który wcześniej tworzył programy w Algolu-58 dla swoich wczesnych maszyn, pracował nad implementacją języka przez kilka miesięcy wakacji w Burroughs.

Kompilator Burroughs Algol był bardzo szybki - zrobiło to ogromne wrażenie na słynnym holenderskim naukowcu Edsgerze Dijkstra (Edsger Dijkstra). Podczas testowania B5000 w Pasadenie jego program został skompilowany z prędkością odczytu z kart perforowanych, co było niesamowitym wynikiem jak na tamte czasy, i od razu zamówił kilka maszyn dla Politechniki w Eindhoven w Holandii, gdzie pracował. Obsługa sprzętu i wystarczająca ilość pamięci RAM pozwoliły kompilatorowi działać w trybie jednoprzebiegowym (chociaż nawet wczesne asemblery maszyn prawie zawsze używały w tamtym czasie kompilacji wieloprzebiegowej).

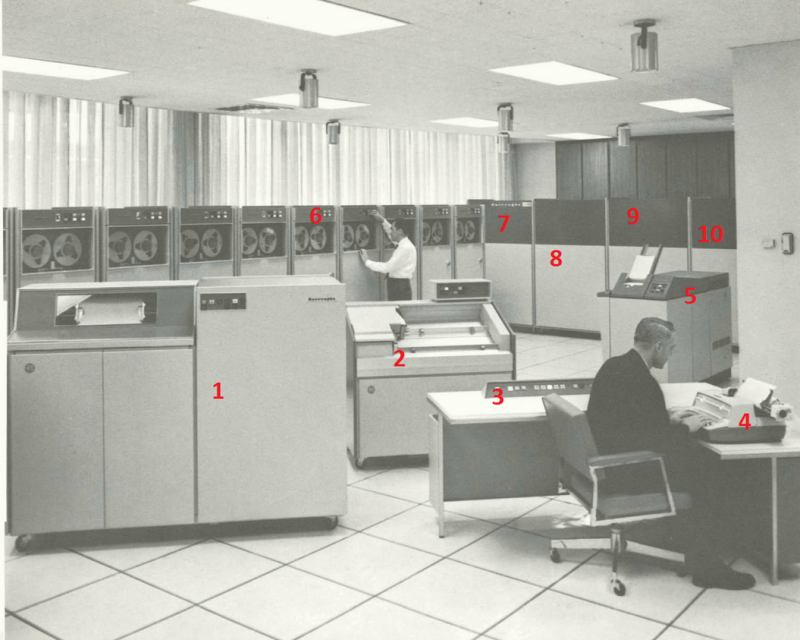

B5500 i jego komponenty.

1 - drukarka (B320, B321 lub B325), 2 - czytnik kart perforowanych (B129), 3 - konsola sterująca z 4 - dalekopis do wprowadzania poleceń (na przykład Teletype Corp Model 33 KSR), 5 - dziurkacz (B303 lub B304) , 6 - napędy taśmowe (B422/B423 -15 Mbps), 7 - procesor (jeden z dwóch możliwych), 8 - koprocesor I/O, 9 - kontroler terminala, 10 - konsola wyświetlająca i debugująca. Również 2 szafy z pamięcią RAM i druga szafa procesora nie zmieściły się na zdjęciu (fot. University of Tasmania http://www.retrocomputingtasmania.com)

Rozważamy wszystkie te zalety tak szczegółowo właśnie dlatego, że podobne pomysły przyszły do grupy Judyckiego, a później do grupy Burcewa (tylko Judycki, w przeciwieństwie do Burcewa, nie miał pod ręką żywego Burroughsa do badań). W efekcie wiele rzeczy określanych jako unikatowe i niespotykane na skalę światową, zaimplementowanych w Elbrusie, pojawiło się w rzeczywistości dużo wcześniej, w tym zaawansowane mechanizmy zabezpieczające.

Nawet ulepszony Burroughs Algol nie zawierał wielu niebezpiecznych konstrukcji wymaganych przez system operacyjny i inne oprogramowanie systemowe. Aby je wspierać, opracowano specjalne rozszerzenie Espol (Executive Systems Problem Oriented Language). Espol posłużył do napisania rdzenia systemu operacyjnego - Burroughs MCP (Master Control Program) oraz całego oprogramowania systemowego. Wsparcie sprzętowe firmy Espol ułatwiło wdrożenie pamięci wirtualnej, przetwarzania wieloprocesowego, szybkiego przełączania kontekstu i wywoływania procedur, ochrony pamięci i współdzielenia kodu. B5000 był pierwszą komercyjną maszyną z pamięcią wirtualną. Ponadto dzięki temu pełne ponowne wprowadzenie kodu zostało zrealizowane w sposób naturalny, bez dodatkowych wysiłków ze strony programistów. Język Espol został zastąpiony bardziej zaawansowanym Newp (New Executive Programming Language) pod koniec lat siedemdziesiątych.

Wszystkie niebezpieczne konstrukcje w programie są odrzucane przez kompilator Newp, chyba że blok w pamięci RAM jest specjalnie oznaczony specjalnym znacznikiem zezwalającym na te instrukcje. To oznaczenie blokowe zapewnia wielopoziomowy mechanizm ochrony. Ponadto programy Newp, które zawierają niebezpieczne konstrukcje, nie są natywnie wykonywalne. Specjalny administrator bezpieczeństwa systemu może uczynić je wykonywalnymi, ale zwykli użytkownicy nie. Nawet uprzywilejowani użytkownicy, którzy zwykle mają uprawnienia administratora, nie mogą ich uruchamiać bez wyraźnej zgody administratora. Tylko kompilatory wyznaczone przez system operacyjny mogły tworzyć pliki wykonywalne z rozszerzonymi poleceniami i tylko sam MCP mógł wyznaczyć program jako kompilator (za pomocą polecenia konsoli administratora bezpieczeństwa).

Newp był tak zaawansowany, że był obsługiwany przez architekturę mainframe Unisys ClearPath, następcę oryginalnej serii B, do 2014 roku, kiedy rozpoczęła się migracja x86. Ponadto na długo przed bashem w systemie Linux opracowano oddzielny język wiersza poleceń, WFL (język przepływu pracy), aby skutecznie kontrolować MCP. W komputerach mainframe IBM jego odpowiednikiem był słynny Job Control Language (JCL).

Komputery zaprojektowane specjalnie dla HDL były bardzo złożone, ale później rozwijały się drogą utartą przez Burroughsa, aż do połowy lat 1980. architekturę x86 i procesory RISC ogólnego przeznaczenia.

Deskryptory chronione tagami w B5000 są sprawdzane sprzętowo przy każdym dostępie do pamięci na każdym etapie zmiany danych. Ponadto system nie musi ręcznie sterować przydziałem pamięci, a ponadto jest to generalnie niemożliwe. Każdy segment chronionych danych, takich jak kod, nie może być nawet odczytany, nie mówiąc już o modyfikacji, w sposób nie kontrolowany przez system, co sprawia, że większość ataków jest po prostu niemożliwa, a błędy niewykonalne.

Oczywiście odpowiedni proces uprzywilejowany może jawnie zmienić bity znacznika, a tym samym zmienić się, ale tylko kompilator ESPOL może wygenerować taki kod, a MCP odmówi wykonania czegokolwiek, co jest przez niego identyfikowane jako ESPOLCODE, bez względu na uprawnienia poziom, jaki ma osoba, która próbuje go uruchomić. . Takie programy muszą być instalowane jako część systemu operacyjnego na samym początku i zasadniczo niemożliwe jest ich dodanie lub zmiana podczas pracy.

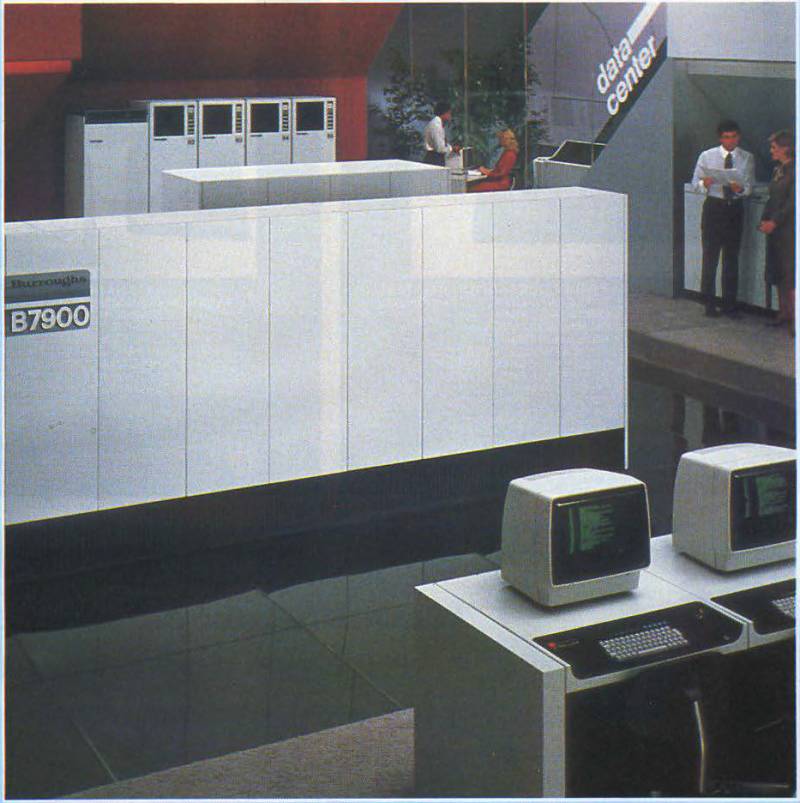

W rezultacie komputery typu mainframe Burroughs pozostały najbezpieczniejszymi i najbezpieczniejszymi maszynami na świecie przez następne trzydzieści lat, dlatego Rezerwa Federalna Stanów Zjednoczonych wybrała je jako standard dla swojego komputera bankowego na wiele lat. Jak już powiedzieliśmy, ta architektura (oczywiście ciągle ulepszana o nowe modele) była wspierana sprzętowo do niedawna i dopiero od 2014 roku nastąpiło przejście na standardowe serwery x86.

Jednym z niewielu prawdziwych problemów z serią B było to, że jej poprzednik, B5000, miał niezwykle złożony procesor i podsystem pamięci. W dobie maszyn tranzystorowych można było na to przymknąć oko, ale ten moment bardzo skomplikował integrację kolejnych modeli. W tamtych latach, kiedy wszyscy producenci przestawili się na modele jednoukładowe, z procesorem realizowanym jako niestandardowy obwód, seria dużych maszyn Burroughs była nadal produkowana w wersjach wieloukładowych.

Pierwsza wersja „mainframe on a chip” – SCAMP, pojawiła się dopiero pod koniec lat 1980., kiedy było już za późno, chociaż ten procesor i jego następcy były używane przez Unisys do połowy lat 2000.

Dodatkowym problemem była niezawodność ze względu na ogromną złożoność procesora oraz ogromną liczbę tranzystorów i wczesnych układów scalonych.

Jednak komputery Burroughs nie mogły się zepsuć – firma miała reputację jednego z najlepszych dostawców systemów wysokiej dostępności, ich maszyny tradycyjnie pracowały przez lata bez awaryjnego zatrzymania (a także notabene ich maszyny sumujące, które były do tego czasu słusznie uważany za najbardziej niezawodny w branży). W system wbudowano znaczną redundancję i elastyczność, aby zapewnić, że B5000 spełnia surowe kryteria jakości.

Moduły sprzętowe można było odłączać i instalować w locie, bez przerywania pracy i bez utraty danych, co w tamtych czasach było czymś fantastycznym. Aby monitorować stan wszystkich węzłów maszyny i rekonfigurować system w procesie obliczeń, omijając wadliwe sekcje, dodano specjalny koprocesor MDLP (procesor Maintenance Diagnostic Logic, procesor konserwacji). Był również używany przez inżynierów do diagnozowania wszystkich elementów systemu.

W rezultacie, pomimo faktu, że B5000 był o rząd wielkości bardziej skomplikowany niż tradycyjne maszyny tamtych lat, jego niezawodność nie tylko nie ucierpiała, ale także znacznie przewyższyła większość komputerów tej klasy.

Autorytet firmy w środowisku bankowym był tak wysoki, że w 1973 roku, kiedy powstało Towarzystwo Światowej Międzybankowej Telekomunikacji Finansowej (SWIFT – Society for Worldwide Interbank Financial Telecommunications), to właśnie Burroughs w ciągu 4 lat zbudował swoje szkieletowe systemy komutacyjne praca. Do dziś spadkobierca Burroughsa, Unisys Corporation, jest największym dostawcą sieci SWIFT.

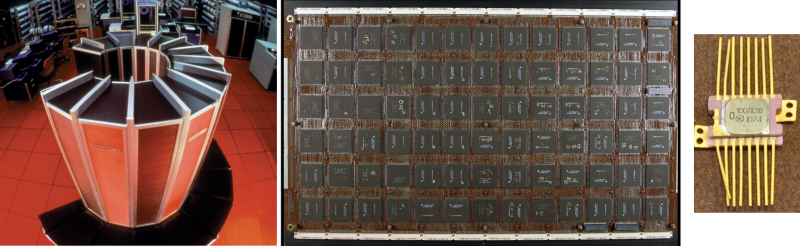

„Desktop mainframe” Unisys Micro A (1989) jest właściwie pierwszym serwerem we współczesnym znaczeniu tego słowa. Jego procesor to SCAMP-A (na górze), a później SCAMP-D (1997, na dole). Na zamówienie Unisys chipy zostały wyprodukowane najpierw przez IBM w ich fabrykach, a następnie przez LSI. Serwer Unisys ClearPath Libra 6200 (2012-2015) jako ostatni obsługuje architekturę B5000 (fot. University of Tasmania http://www.retrocomputingtasmania.com, z prywatnej kolekcji Johna Culvera https://www.cpushack .com/ i oficjalna broszura Unisys ClearPath)

B5000 był używany przez NASA, US Air Force, Carrier Corporation, University of Washington, University of Denver, Caltech, Stanford University, Monash University w Australii (były one lojalne wobec Burroughsa do końca i posiadały wszystkie swoje maszyny z rzędu aż do B7800), Drexel Institute of Technology w Montrealu, British Post i American Bureau of Mines.

Również w 1964 roku Burroughs zbudował B8300 do zastosowań w czasie rzeczywistym, takich jak rezerwacja biletów lotniczych. Jako język systemu wybrano dość rzadką wersję Algola 60 - Jovial. Został opracowany w 1959 roku jako nowy język programowania wysokiego poziomu dla systemów czasu rzeczywistego w SDC Corporation przez grupę kierowaną przez Julesa I. Schwartza i pierwotnie był dialektem Algol-58, na co wskazuje jego zabawna nazwa (Jules Own Version Międzynarodowego Języka Algebraicznego).

Początkowo był przeznaczony do programowania elektroniki samolotów bojowych, ale w latach 1960-tych stał się ważną częścią szeregu amerykańskich projektów wojskowych, w szczególności SACCS (Strategic Automated Command and Control System – system kontrolujący broń jądrową bronie USA) i oczywiście SAGE. Około 95% oprogramowania SACCS (opracowanego wspólnie przez ITT i IBM) zostało napisane przez SDC w Jovial. Rozwój zajął dwa lata (w przeliczeniu na około 1400 roboczogodzin), ponad dwukrotnie szybciej niż oprogramowanie dla SAGE.

Podczas opracowywania standardowej architektury procesora wojskowego MIL-STD-1970A pod koniec lat 1750. zdecydowano, że Jovial pozostanie podstawowym językiem dla tej architektury. Wiele firm dostarczyło do tego swoje kompilatory - Advanced Computer Techniques (ACT), TLD Systems, Proprietary Software Systems (PSS) i inne. Najnowszy standard dla tego języka, MIL-STD-1589C, został przyjęty w 1984 r. Obecnie nadal w użyciu są trzy dialekty tego standardu: J3, J3B-2 i J73. Wsparcie dla Jovial zostało usunięte dopiero w 2010 roku, chociaż kompilatory nadal są wydawane.

Podobnie jak w przypadku Cobol, większość oprogramowania zaimplementowanego w Jovial ma krytyczne znaczenie dla misji, a konserwacja staje się coraz trudniejsza, a częściowe wymiany rozpoczną się w 2016 r., chociaż czasami wybór jest więcej niż dziwny. Na przykład oprogramowanie słynnego bombowca B-2 zostało przeniesione z Jovial do Pure C (!), co trudno uznać za skuteczne rozwiązanie pod względem bezpieczeństwa i łatwości obsługi.

W przybliżeniu tę samą architekturę zaproponowali inżynierowie SVT, tylko ich superkomputer miał jeszcze jedną unikalną cechę - był, jak już powiedzieliśmy, modułowy!

Nowy komputer Judycki

Nowa maszyna Judyckiego miała zawierać podsystemy centralnego przetwarzania (do 16 procesorów centralnych), wejścia-wyjścia (do 16 procesorów wejścia-wyjścia), pamięci (do 32 sekcji pamięci RAM 32K x 64-bitowe słowa) oraz potężnego modułowy system do dynamicznego przełączania tych modułów na złożonym wykresie (dowolny procesor może być podłączony do dowolnego PVV i dowolnej sekcji pamięci RAM). Ogólna wydajność komputera została oszacowana na absolutnie monstrualne 200 MIPS - Cray-1 z 1977 roku dawał 160! W procesorze zaplanowano oczywiście tabelaryczną implementację arytmetyki.

W rezultacie Yuditsky z zadowoleniem stwierdził, że pomimo niezwykle nietypowego dla superkomputerów systemu klas rezydualnych, jego nowy projekt będzie w stanie pokonać M-10 Kartseva! To naprawdę była absolutnie wyjątkowa hybryda, która wchłonęła wszystkie najbardziej zaawansowane światowe osiągnięcia w dziedzinie komputerów tamtych lat, architekturę macierzy równoległej z serii M, wsparcie sprzętowe dla NVU z B5000 i oczywiście zastrzeżoną technologię Yuditsky'ego sam - SOK.

Najbardziej uderzające jest to, że wynik wcale nie wyglądał jak skrzyżowanie jeża z wężem - to było absolutnie sprawne, niezwykle wygodne i najmocniejsze auto na świecie tamtych lat, najbliżsi amerykańscy konkurenci byli o pokolenie do tyłu . Poza tym była niesamowicie niezawodna.

Ogólnie rzecz biorąc, wszyscy już rozumiemy, że nie byłoby możliwe przetłumaczenie tego na serię w ZSRR, nawet kosztem życia głównego projektanta.

Aby zaimplementować arytmetykę tablicową, maszyna potrzebowała nowej kompaktowej pamięci stałej o dużej pojemności. Od kilku lat oddział S. A. Garyainova rozwija go w SVT. Istotą pracy było stworzenie bezpakietowych matryc diodowych, a także zaprojektowanie i technologia wykonania opartych na nich urządzeń.

Właśnie w tym celu chcieli zaadaptować wspomnianego już DMR-256. Na podstawie matrycy opracowano odpowiedni oryginalny system konstrukcyjny: kryształy DMR zamontowano na płycie sitalowej, płyty ułożono w siedmiopiętrowy stos MFB (wielofunkcyjny blok), stosy zainstalowano na dużym krzyżu z nadrukiem tablica. Kilka crossboardów zamontowano w metalowej, hermetycznej obudowie blokowej wypełnionej freonem. Aby usunąć ciepło z bloku, zainstalowano w nim rury cieplne.

Wstępny projekt unikalnego komputera, po prostu indeksowanego cyframi rzymskimi „IV”, został ukończony na początku 1973 roku. „IV” został pomyślany jako prototyp dla późniejszego rozwoju SVT. Jednak jeszcze przed zakończeniem projektu wydawało się, że został dobrze wykorzystany.

Pod koniec 1971 r. Biuro projektowe Suchoj „Kulon” zwróciło się do SVT z zamówieniem na opracowanie CAD dla samolotów. Na CAD nałożono wysokie i obiecujące wymagania, wyprzedzające wszelkie możliwości radzieckich komputerów tamtych lat.

System miał obsługiwać ponad 700 stacji roboczych dla twórców samolotu i jego podzespołów. Każda stacja robocza była terminalem z ploterem graficznym, a obliczenia musiały być wykonywane na głównym superkomputerze (w tamtych czasach roczna wydajność nawet prostszych stacji roboczych w ZSRR nie przekraczała pół tysiąca). Wstępny projekt został ukończony i zaakceptowany z satysfakcją przez klienta, jednak Ministerstwo Przemysłu Radiowego (nie wiadomo kto na czele) odmówiło produkcji samochodu, powołując się na brak funduszy (mimo że projekt był przeznaczony dla wojskowego biura projektowego i nie szczędziliśmy pieniędzy na przemysł obronny).

Jednak jeszcze ciekawsze zastosowanie dla „IV” pojawiło się niemal natychmiast, na początku 1972 roku. Następnie SVT otrzymały od samego GRU zamówienie na opracowanie projektu superkomputera do przetwarzania danych ustrukturyzowanych w specjalny sposób (tłumaczenie z języka GRU na język ludzki - do łamania szyfrów), który otrzymał kryptonim „Maszyna 41 -50".

Komputer 64-bitowy musiał mieć prędkość co najmniej 200 MIPS, 16 MB pamięci RAM i zaawansowane peryferia. W SVT postanowili zbudować komputer wektorowy z systemem poleceń pracujących na tablicach i skupili się na implementacji algorytmów klienta. Problem dynamicznej równoległości został rozwiązany na poziomie sprzętowo-mikroprogramowym. Projekt projektu 41-50 SVT realizowany wspólnie z Instytutem Cybernetyki Akademii Nauk Ukrainy, inny niedoceniony sowiecki geniusz, jeden z najlepszych na świecie specjalistów w dziedzinie obliczeń równoległych i dyrektor IC, akademik W. M. Głuszkow, brał udział w praca.

Warto jakoś osobno rozpocząć rozmowę o Głuszkowie – był on jednym z największych światowych naukowców w dziedzinie informatyki (w 15. Głuszkow!), ale jego projekty (i były absolutnie niesamowite rzeczy, na przykład sowiecki Internet) utonęły tak bezwzględnie, że (już zgodnie z tradycją wybitnych krajowych specjalistów komputerowych) nie dożył 1973 lat, umierając zawału serca.

Głuszkow został mianowany dyrektorem naukowym projektu, w IK powstały dwie jednostki specjalne (oddział Ogólnorosyjskiego Centrum Centralnego) kierowane przez Z. L. Rabinowicza i B. N. Malinowskiego. Głównym projektantem był Juditsky.

Projektowanie 41-50 rozpoczęto od przestudiowania algorytmów rozwiązywania problemów klientów i próby dopasowania ich do arytmetyki modułowej (jak widać we wszystkich projektach maszyn SOK praca opierała się na algorytmach - w rzeczywistości była to wada tej klasy komputerów - ogromne przywiązanie do konkretnych zadań, czyniące auto niemal wysoce wyspecjalizowanym). Pracami kierowali VM Amerbaev jako matematyk i główny autor arytmetyki modularnej oraz LG Rykov jako inżynier obwodu wdrażający te algorytmy.

Wspomina L. G. Rykowa:

Wynik badań został zebrany w pracy RTM U10.012.003 „Algorytmy maszynowe dla dwuetapowej arytmetyki niepozycyjnej” i ogólnie był rozczarowujący. Faktem jest, że w zadaniach GRU odsetek operacji niemodułowych był ogromny, nie dało się ich zredukować do SOC, a ciągłe konwertowanie tam iz powrotem i wpędzanie ich w zwykły koprocesor było głupotą.

W rezultacie wydajność bardzo złożonego i wydajnego komputera nie przekraczałaby wydajności zwykłego superkomputera o tradycyjnej architekturze. Ogólnie rzecz biorąc, system SOC dawał premie ze względu na niezawodność, łatwość implementacji arytmetyki tabelarycznej i zmniejszenie ilości sprzętu, ale Yuditsky nie był fanatykiem i rozumiał, że arytmetyka modułowa nie jest srebrną kulą. Są przypadki, w których po prostu nie pasuje do algorytmów, pomimo wszystkich sztuczek.

W finale, po dyskusjach i dyskusjach, SVT zdecydowały się zrezygnować z SOC, zachowując ogólny wektorowo-modułowy schemat maszyny i zrewidować projekt. Taka elastyczność korzystnie odróżniała ich od wielu radzieckich biur projektowych, które po znalezieniu mniej lub bardziej udanego rozwiązania technicznego nadal fanatycznie je stemplowały (jak tranzystorowe wersje BESM we wszystkich wersjach i własny system dowodzenia, niezwykle skuteczny w niektórych zadaniach i do tej samej skrajnej krzywej - na innych).

Postanowili zrobić samochód oczywiście na układzie scalonym i wzięli za podstawę najpotężniejszą wówczas logikę sprzężoną z emiterem z serii 100 w ZSRR. Zanim został skradziony, nazywał się Motorola MC10000 (alias MECL - Motorola logika sprzężona z emiterem) - seria dość mocnych i szybkich mikroukładów ESL, opracowanych w 1962 roku (MECL I). Seria składała się z kilku generacji - I, II, III i 10000 1971, wydanych w 1968 roku. Różnił się jednak od wersji z 7 roku jedynie wartościami rezystorów. Po 100 latach udało się go skopiować w ZSRR jako ISXNUMX, był przeznaczony do najpotężniejszych komputerów, takich jak Elbrus.

Niestety mikroukłady tej serii okazały się dla Unii niezwykle trudne i miały ogromne problemy z jakością i stabilnością, co jest notoryczne (o IS100 porozmawiamy w części o A-135 i Elbrusie, diabeł się złamie swoją nogę w kopiowaniu potężnych ESL-ów w ZSRR, a ten temat należy rozpatrywać osobno, jest on ściśle powiązany ze stosunkami handlowymi dwóch gigantów – Motoroli i Fairchilda).

Na Zachodzie Motorola 10k nie była najpopularniejszym wyborem dla konstruktorów superkomputerów; do tych celów najczęściej wykorzystywano ESL od konkurenta Fairchild, serię Fairchild F100K (później próbowaliśmy ją skopiować z 10-letnim opóźnieniem dla Elektroniki SS BIS - serii K1500, wynik był, no powiedzmy – niezbyt udany, to też temat na osobne omówienie). To było na F100K (3 chipy z 4 użytych typów - 11C01, F10145, F10415 i tylko jeden MC10009 dla obwodu próbkowania adresu, Cray użył tańszego w miejscu, w którym nie był krytyczny) Cray-1 został zmontowany.

Wielki i straszny Cray-1, jedna z płyt jego procesora na układach Fairchild F100K i sowiecki klon Motoroli 10k - 100 z okresu rozwojowego (fot. https://cdn.britannica.com/, https:// en.wikipedia.org/, https://ru-radio-electr.livejournal.com/)

Produkcja IS100 została opanowana w zakładach Mikron, Venta w Wilnie, Svetlana w Leningradzie i Integral w Mińsku. Potem zaczęły się problemy, skład serii nie przewidywał układów wektorowych, w wyniku czego wymagane były dodatkowe układy scalone, których nie było w programie wydawniczym.

Postanowiono połączyć się z programem, opracowując dla niego brakujące mikroukłady. Otwarto temat Yukoli, w ramach którego określono skład układów scalonych wymagających opracowania (było ich całkiem sporo - 14, zauważamy, że w pełni wektorowy Cray był montowany ogólnie tylko na 4 typach mikroukłady, aw ALU zastosowano tylko jeden typ) i opracowano ich schematy funkcjonalne i schematyczne. Projekt i rozwój technologiczny tych układów scalonych planowano przeprowadzić wspólnie z NIIME w ramach przygotowania projektu roboczego 41-50.

Wstępny projekt komputera został zaakceptowany przez państwową komisję z wysoką oceną i zaleceniem kontynuowania prac. Jeden z ideologów 41-50 N. M. Vorobyov tak wspomina finał wydarzeń:

Jednak nieoczekiwanie dla nas nastąpiła długa, kilkumiesięczna, niewytłumaczalna przerwa. Zawarcie umowy na wykonanie projektu technicznego zostało przesunięte. Nie wiedzieliśmy, co tam się dzieje – GRU to poważna organizacja. Ale kiedy decyzja zapadła, specjalnie do nas przyjechali pułkownicy, żeby wyjaśnić sytuację. Panowie ze smutkiem i przeprosinami („Staliśmy za wami jak mogliśmy”) przekazali nam smutną wiadomość: nie będzie kontynuacji prac.

Zdecydowano się wykorzystać Elbrusa przystosowanego do ich zadań, ale nie wierzą w możliwość adaptacji, gdyż nie ma dźwigni zapewniających jej realizację.

Oczywiście Ministerstwo Przemysłu Radiowego nie mogło się bez niego obejść, ponieważ planowano wyprodukować 41-50 w swoich zakładach.

Finał projektu SVC

W ten sposób zakończył się kolejny projekt SVT dotyczący stworzenia superkomputera.

A. I. Abramov, przedstawiciel generalnego klienta w SVT, wspomina jego finał:

Należy zauważyć, że rozwój BESM-10 ITMiVT faktycznie się nie powiódł, nie robiąc nic praktycznego w tym temacie, szkoła Lebiediewa w ogóle nie wiedziała, jak pracować z technologiami superkomputerowymi.

Ich dwa największe osiągnięcia to BESM-6 (którego wszyscy nie mieli dość, bo nie mieli nic innego), z wydajnością zaledwie około 1-1,5 MIPS i wyjątkowo brzydkim i niewygodnym systemem dowodzenia, nie wspominając już o jego braku arytmetyki parzystych liczb całkowitych (Lebiediew nigdy nie był wybitnym systemowym architektem komputerów) oraz kontrowersyjny Elbrus Burcewa, który był wyraźnie lepszy od tworów jego szefa, ale nie mniej niewygodny i daleki od produktywności jak praca SVT . Ponadto jakość produkcji maszyn opracowanych przez ITMiVT była fatalna, o tym również porozmawiamy później.

System 41-50 był najnowszym osiągnięciem superkomputerów w SCC.

Trzy projekty z rzędu nie powiodły się, a przez to samo ministerstwo - 5E53 z powodu tego, że maszyna stworzona specjalnie dla algorytmów obrony przeciwrakietowej (i zaakceptowana przez wojsko i PROshniks!) rzekomo nie jest zdolna do implementacji tych algorytmów, „IV” – pod pretekstem braku pieniędzy, a nawet okropne GRU musiało zadowolić się wbitym w zęby Elbrusem, nie mogąc przepchnąć się przez partyjnych biurokratów 41-50, co ponownie zostało przez nich entuzjastycznie przyjęte i w pełni zgodne z ich TOR.

Ostatni przypadek był ogólnie rażący - Ministerstwo Przemysłu Radiowego w rzeczywistości odmówiło wydania komputera bez żadnego powodu, walcząc z oficerami wywiadu jak irytującymi uczniami. Nie kupimy Ci pięknego auta, nie będziemy bawić się żeliwem.

W rezultacie Yuditsky zdał sobie sprawę, że sensowne jest rozwijanie tylko tego, co można wyprodukować w obiektach samych SVT - 16-bitowych minikomputerów. Oczywiście zastosowanie arytmetyki modułowej nie dawało im żadnych specjalnych korzyści, a projekt SOC został całkowicie ograniczony na zawsze.

Istnieje legenda cytowana przez akademika V. M. Amerbaeva i znana tylko z jego słów:

O tej samej sprawie i być może o innej wspomina V. S. Linsky:

Właściwie to dość dziwne historia, modułowa arytmetyka mogłaby pomóc w komputerach bankowych, ale głównym producentem komputerów bankowych był Burroughs, który opierał się na zupełnie innych zasadach architektury systemu. Być może była to jakaś firma, która chciała obalić monopolistę, ale na tym rynku nie ma zbyt wielu poważnych graczy. Mała firma nie miałaby takich pieniędzy, duża, jak IBM, w zasadzie rozwijała wszystko sama i znowu była tak konserwatywna, jak to tylko możliwe. Ponadto wszystkie informacje (no, z wyjątkiem algorytmów obrony przeciwrakietowej) o SOC były już w otwartej prasie, nawet bez stempla płyty wiórowej. Kilku dobrych matematyków szybko to rozgryzie.

Cóż, ogólnie rzecz biorąc, Stany Zjednoczone bardzo dobrze wiedziały, że ZSRR jest bardzo, bardzo zainteresowany wydobyciem zachodniej technologii wszelkimi sposobami (od demontażu radiogramów przekazywanych prywatnie różnym dyplomatom na próbkę, po kupowanie licencji i jawną kradzież), ale zasadniczo nie sprzedawałby żadnych zaawansowanych technologii.

Na przykład wypuszczenie na rynek komputera Setun zostało zakazane nawet przez ich rodzimą Czechosłowację, choć Czesi błagali niemal na kolanach, obiecywali ogromne zyski ze sprzedaży do Europy Zachodniej i byli już gotowi do budowy linii produkcyjnej (choć istnieje silna podejrzenie, że przyczyny tego nie były związane z polityką, ale z magicznymi słowami „cięcie” i „cofnięcie”, dość istotnymi w czasach ZSRR, jak pamiętamy, pewne kręgi w Czeskiej Partii Komunistycznej zmiażdżyły własne rozwoju, rzucając miliony koron na zakup od samych Francuzów upragnionych komputerów typu mainframe firmy Bull). Tak więc negocjacje tutaj były początkowo skazane na niepowodzenie i głupotą byłoby tego nie rozumieć.

AV Pivovarov wspomina inny przypadek:

Judicki przyszedł do mnie po zgodę na taki układ, ale odmówiłem mu z dwóch powodów.

Po pierwsze, aby zrealizować taką transakcję, konieczne jest wyprodukowanie przykładowego komputera do pełnego rozwoju technologii, ale nie było gdzie tego zrobić.

Po drugie - po co więc mielibyśmy uzbrajać Francuzów - naszych potencjalnych przeciwników militarnych? Tak, nawet gdybym się zgodził, i tak nie pozwoliłyby nam na to wyższe władze.

Ta historia jest już znacznie bardziej realistyczna, z Francją ZSRR współpracował zaskakująco i owocnie zarówno w dziedzinie nauk podstawowych, zwłaszcza matematyki, jak i nauk stosowanych, w tym farmacji, do Francji, a także do Niemiec, gdzie nasi naukowcy byli zwalniani częściej chętniej też odbywała się wymiana sprzętu, choć ograniczona.

Yuditsky opublikował ponad 60 monografii i artykułów na temat SOC, stając się jego największym teoretykiem, uzyskano wiele patentów na wszystkie węzły i algorytmy, niektóre nawet w Niemczech, Francji, Wielkiej Brytanii, Włoszech i USA, więc absolutnie jasny przekaz Ministerstwa Przemysłu Radiowego „usiądź i nie wychylaj się, nic, co zrobisz, nigdy nie zostanie ujawnione” doprowadziło do poważnego szoku psychicznego i ogromnego rozczarowania całego zespołu SVTS. Pamiętajmy ile czasu i wysiłku poświęcono na rozwój, ile obróbki, nocnych zmian, czuwania do rana z lutownicą i oscyloskopem, ile nadziei i oczekiwań, kiedy opracowania zostaną ucieleśnione w metalu…

Trzy poważne niepowodzenia z rzędu, i to bez własnej winy, to dużo dla każdej grupy naukowej.

W rezultacie aktywność naukowa SVT spadła niemal do zera, podczas gdy zespół podnosił się po bitwie z Ministerstwem Przemysłu Radiowego. W rezultacie temat arytmetyki modułowej został całkowicie okrojony w ZSRR, według niektórych źródeł zagraniczni naukowcy, którzy to zaobserwowali (i oczywiście nie znali prawdziwych przyczyn wydarzeń), uznali, że było to spowodowane zupełna bezcelowość całego kierunku, a także drastycznie zmniejszyła się intensywność pracy na maszynach SOK.

50. rocznica arytmetyki modułowej

W Unii całkowicie zapomniano o komputerach modułowych, w Rosji - tym bardziej, aż do 2005 roku, kiedy to minęło 50 lat od pierwszej publikacji Wołocha i Swobody na ten temat. Wtedy pozostali przy życiu pracownicy SVT postanowili jednocześnie upamiętnić swój wkład w ten kierunek, uczcić pamięć wszystkich, którzy brali udział w projektowaniu komputerów modułowych i dowiedzieć się, czy gdzieś indziej zrealizowano podobne projekty?

I zainicjowali specjalną konferencję w Zelenogradzie „50 lat arytmetyki modułowej”. Była bardzo udana, wzięło w niej udział 49 delegatów, reprezentujących 32 firmy z Rosji, Białorusi, Kazachstanu, Ukrainy i Stanów Zjednoczonych, którzy sporządzili 44 sprawozdania, wydano blisko tysiącstronicowy zbiór referatów.

Obecnie warianty arytmetyki modułowej są szeroko stosowane w mikrokontrolerach kart dostępowych o wysokim poziomie bezpieczeństwa do realizacji algorytmów kryptograficznych, zgodnie z normą ISO/IEC 10118-4:1998 (sekcja Hash-funkcje wykorzystujące arytmetykę modularną). Takie klucze są produkowane głównie przez firmę STMicroelectronics. Ponadto mikrokontrolery do kryptografii były lub są produkowane przez M-Systems (kontroler SuperMAP), Emosyn LLC (oddział ATMI, układ Theseus Platinum), Hifn i inne.

Na początku 2010 roku V. M. Amerbaev i A. L. Stempkovsky z IPPM RAS pracowali także nad alternatywnymi wersjami systemów niepozycyjnych, na przykład tzw. używany jest logarytm modułu liczby. Przy takiej reprezentacji liczb operacje dzielenia i mnożenia są znacznie uproszczone, co jest logiczne, ale cyfrowa realizacja operacji addytywnych - dodawania i odejmowania - staje się bardziej skomplikowana. W rezultacie powstały jeszcze bardziej egzotyczne hybrydy, takie jak modułowy kod LG. Wykorzystuje liczby pierwsze jako podstawy i wykorzystuje logarytmiczną reprezentację reszt dla każdej zasady pierwszej. Ze sprzętowego punktu widzenia schemat ten można wykorzystać do budowy niezwykle wydajnych procesorów DSP, ponieważ kod LG znacznie przyspiesza jedną z głównych operacji takiego procesora, transformatę Fouriera.

Ponadto w układach procesorów specjalnych AFK „Vychet-1” i „Vychet-2” zastosowano szeregowo modułowe procesory (praktycznie niemożliwe było znalezienie informacji na ich temat i nie wiadomo, czym były i do czego służyły ) oraz środki ochrony kryptograficznej linii komunikacyjnych - produkty KRYPTON-4M7 i SEKMOD-K. Informacje o KRYPTON są skromne, ale dostępne. Jest to dekoder szyfrujący do telefonu, jego podstawą jest modułowy 32-bitowy DSP, który realizuje funkcje szyfrowania mowy i przesyłania jej z prędkością 2400-12000 bodów.

Obecnie artykuły na temat modułowych układów scalonych pojawiają się okresowo w Rosji (na przykład Kalmykov I. A., Sarkisov A. B., Yakovleva E. M., Kalmykov M. I. Modułowy skurczowy cyfrowy procesor sygnałowy o rekonfigurowalnej strukturze, Vestnik Severo- Caucasian Federal University No. 2 (35) / 2013 ), ale raczej powolnie, a sprawa nie posunęła się dalej niż rozwój teoretyczny.

Historia pokazała, że SOC jest niezwykle wygodny w raczej wąskich zastosowaniach - systemach odpornych na uszkodzenia, kryptografii klucza publicznego i cyfrowym przetwarzaniu sygnałów, i niezbyt wygodny - we wszystkim innym. Jako taki jest obecnie używany za granicą, jednak szkoda, że wybitni pionierzy w tej dziedzinie, sowieccy inżynierowie, zostali na długo zapomniani, a ich unikalne dzieła nie przyniosły ojczyźnie ani chwały, ani pożytku.

informacja