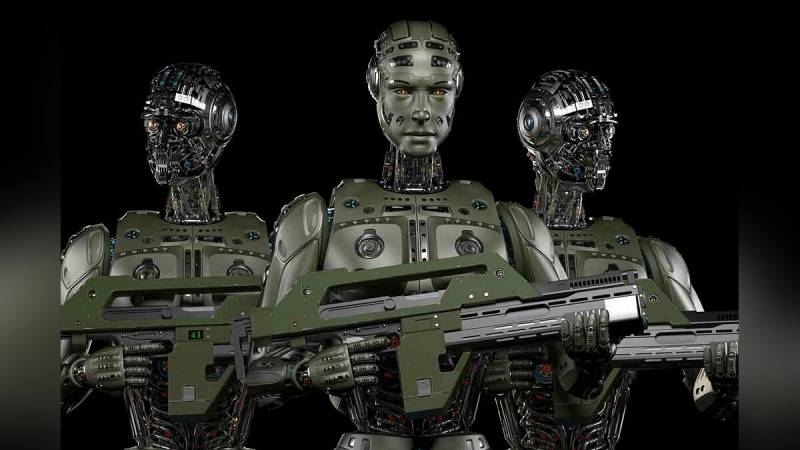

Notatki ludzkiego umysłu: Amerykanie chcą zmienić wojskową sztuczną inteligencję

źródło: vgtimes.ru

Czy anulowana zostanie cyfrowa dehumanizacja?

Najpierw słowo ostrzeżenia od bojowników AI:

Pacyfistów, którzy domagają się zamrożenia wszelkich prac nad bojową sztuczną inteligencją, dzielą się na dwa typy. Pierwszym z nich są zmienione „Terminatory” i inne analogi. Drugi – ocena przyszłości pod kątem współczesnych możliwości robotów bojowych. Przede wszystkim uskrzydlone pojazdy bezzałogowe wyposażone w systemy uderzeniowe.

Wystarczająco dużo jest przypadków błędnego lub celowego niszczenia ludności cywilnej przez drony. Na Bliskim Wschodzie Amerykanin drony zniszczył więcej niż jedną ceremonię ślubną. Operatorzy latających robotów zidentyfikowali uroczyste strzelanie powietrze-powietrze jako wyznacznik walk partyzanckich. Jeśli specjalnie przeszkolona osoba nie jest w stanie określić szczegółów celu z kilkuset metrów, to co możemy powiedzieć o sztucznej inteligencji. W tej chwili widzenia maszynowego pod względem adekwatności postrzegania obrazu nie można porównywać z ludzkim okiem i mózgiem. Chyba, że się zmęczy, ale to też rozwiązuje terminowa zmiana operatora.

Nad wojskową sztuczną inteligencją wyraźnie gromadzą się chmury. Z jednej strony jest coraz więcej dowodów na rychły przełom technologiczny w tej dziedzinie. Z drugiej strony coraz częściej słychać głosy za ograniczeniem lub wręcz zakazem prac w tym kierunku.

Kilka przykładów.

W 2016 roku pojawiła się petycja, w której wybitni myśliciele i tysiące innych osób domagali się, by sztuczna inteligencja nie otrzymywała śmiercionośnej broni. Wśród sygnatariuszy są Stephen Hawking i Elon Musk. W ciągu ostatnich siedmiu lat pod petycją zebrano ponad 20 XNUMX podpisów. Oprócz czysto humanistycznych obaw związanych z możliwością niekontrolowanego wyniszczania ludzi, pojawiają się również niekonsekwencje prawne.

Kto stanie przed sądem w przypadku naprawienia zbrodni wojennych popełnionych przez sztuczną inteligencję? Operatora drona, który spalił kilka wiosek z ludnością cywilną, łatwo jest znaleźć i odpowiednio ukarać. Sztuczna inteligencja jest wytworem zbiorowej pracy programistów. Bardzo trudno jest tu przyciągnąć jedną osobę. Alternatywnie można ocenić firmę produkcyjną, na przykład samą Boston Dynamics, ale kto wtedy będzie zaangażowany w produkcję autonomicznych dronów. Niewielu ludzi będzie chciało znaleźć się na ławie oskarżonych drugiego trybunału norymberskiego.

Źródło: koreaportal.com

Prawdopodobnie z tego powodu przemysłowcy i programiści starają się spowolnić rozwój umiejętności bojowych sztucznej inteligencji.

Na przykład w 2018 roku około dwustu firm informatycznych i prawie pięć tysięcy programistów zobowiązało się nie pracować nad autonomicznymi systemami bojowymi. Google twierdzi, że za pięć lat całkowicie zrezygnuje z kontraktów wojskowych w dziedzinie sztucznej inteligencji. Według legendy taki pacyfizm nie jest przypadkowy – programiści dowiedziawszy się, że piszą kody dla systemów wojskowych, zagrozili masowym odejściem. W rezultacie znaleźli rozwiązanie polubowne – realizowane są istniejące kontrakty, ale nowe nie są zawierane. Możliwe, że bliżej daty odmowy pracy nad bojową sztuczną inteligencją, nieustępliwi „programiści” zostaną po prostu zwolnieni, zastępując ich nie mniej utalentowanymi. Na przykład z Indii, które od dawna słyną z tanich zasobów intelektualnych.

Jest też biuro Stop Killer Robots, które wzywa światowych przywódców do podpisania czegoś w rodzaju konwencji zakazującej walki ze sztuczną inteligencją. Jak dotąd bez powodzenia.

Wszystko to sprawia, że wojskowi szukają obejść. Nawet godzina w wyborach nie wygra prezydenta USA, obiecując nie tylko powszechną łaskę LGBT, ale też zakaz ulepszania wojskowej sztucznej inteligencji.

Ludzkie myślenie dla AI

Pentagon wydaje się być u progu jakiegoś przełomu w sztucznej inteligencji. Albo był o tym przekonany. Nie da się inaczej wytłumaczyć pojawienia się nowej dyrektywy regulującej humanizację autonomicznych systemów walki. Kathleen Hicks, zastępca sekretarza obrony USA, komentuje:

Czy słyszałeś wszystkich, którzy są pod wrażeniem autonomicznych robotów-zabójców? Amerykańska sztuczna inteligencja będzie odtąd najbardziej humanitarna. Podobnie jak sami Amerykanie.

źródło: robroy.ru

Problem polega na tym, że nikt tak naprawdę nie rozumie, jak zaszczepić robotom z bronią osławioną „ludzką ocenę użycia siły”. Dokładne brzmienie Konceptu zaktualizowanego pod koniec stycznia ubiegłego roku:

Tutaj, na przykład, jeśli podczas sprzątania domu samolot szturmowy najpierw wrzuci granat do pokoju, a następnie wejdzie do siebie. Czy to jest ludzki osąd? Oczywiście i nikt nie ma prawa go osądzać, zwłaszcza jeśli wcześniej krzyknął „Czy jest ktoś?”. A jeśli autonomiczny robot działa według tego samego schematu?

Ludzki osąd jest zbyt szeroką koncepcją, aby można ją było w jakikolwiek sposób ograniczać. Czy egzekucja rosyjskich jeńców wojennych przez bojowników Sił Zbrojnych Ukrainy jest również ludzkim myśleniem?

Dodatek do Dyrektywy Pentagonu 3000.09 w sprawie autonomicznych systemów walki jest pełen frazesów. Na przykład,

Wcześniej najwyraźniej działali nierozważnie i niezgodnie z prawami wojennymi.

Jednocześnie w prasie amerykańskiej i europejskiej nie ma cienia krytyki styczniowej inicjatywy Pentagonu. Pod fałszywą humanizacją sztucznej inteligencji kryje się nic innego jak próba ukrycia tego, co się dzieje. Teraz wojsko USA będzie miało solidny atut w walce z przeciwnikami sztucznej inteligencji w armii. Słuchaj, nie mamy prostej sztucznej inteligencji, ale z „właściwym poziomem ludzkiego osądu”.

Biorąc pod uwagę, że nadal nie ma jasnej i ogólnie przyjętej definicji „sztucznej inteligencji”, całe tworzenie liter wokół niej odbierane jest z ironią. Co najmniej.

Jak sprawić, by algorytmy matematyczne pracujące z dużymi tablicami danych odgrywały rolę ludzkich osądów?

Odpowiedzi na to główne pytanie nie ma w zaktualizowanej dyrektywie 3000.09.

informacja